Wie Maschinen menschliche Vorurteile bekämpfen

Irgendwann in ferner Zukunft, sitzen bei Gericht keine Richter mehr aus Fleisch und Blut, sondern Maschinen. So skizziert der Technikphilosoph Max Tegmark in seinem Buch „Leben 3.0“ ein futuristisches Szenario.

Die Roborichter fällen auf Basis der vorliegenden Daten, also Fakten und Gesetz, ein Urteil über einen Angeklagten. Und das ganz ohne die mögliche Befangenheit eines menschlichen Richters. Klingt fair, oder?

Was aber, wenn der Roborichter lernen würde, dass zum Beispiel besonders viele Menschen aus einer bestimmten sozialen Gruppe Verbrechen verüben? Würde er dann anfangen auf Basis dieser Daten solche Menschen eher zu verurteilen? Und wo wäre dann noch der Unterschied zwischen maschinellen und menschlichen Vorurteil?

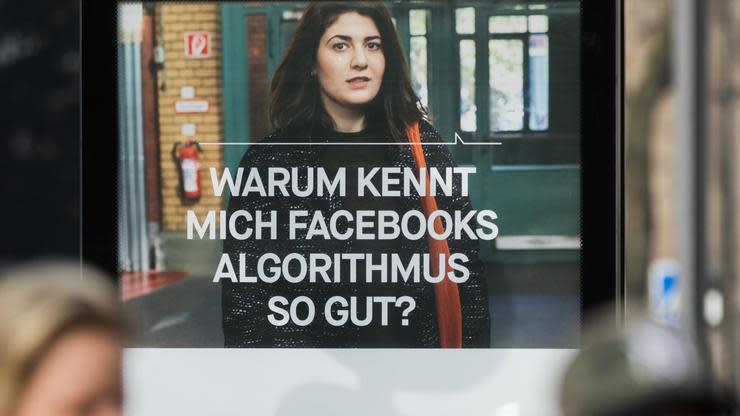

Hinter solchen Szenarien stecken auch die sogenannten Algorithmen – programmierte Handlungsanweisungen, die schon heute immer häufiger über unser Leben entscheiden, im Kleinen wie im Großen.

Sie legen fest, welche Nachrichten wir bei Facebook sehen, entscheiden darüber, ob wir für einen Job in Frage kommen und könnten theoretisch sogar Gerichtsurteile fällen. Auf der Digitalkonferenz Republica ist der Umgang mit automatisierten Entscheidungen eines der zentralen Themen.

Dabei dominiert oft die Angst vor dem Algorithmus: So warnen Experten davor, dass in Zukunft zum Beispiel eine Software über Kreditvergabe, Studienplatz oder Versicherung entscheiden könnte – ohne den individuellen Fall abzuwägen, sondern allein auf Basis von jenen Daten, die den Algorithmus trainieren.

Die Macht von Algorithmen kennt auch Aniko Hannak, Forscherin an der Northeastern University, die darüber auf der parallel zur Republica stattfindenden Media Convention Berlin spricht.

Sie forscht unter anderem daran, wie Algorithmen Vorurteile auf Jobplattformen verstärken: „So zum Beispiel haben wir herausgefunden, dass Profile von Frauen meist niedriger gerankt werden als die von Männern – es gibt eine klare Kluft zwischen den Geschlechter auf derartigen Plattformen.“

Die Gründe dafür sind vielseitig, meint Hannak: „So kann der Algorithmus zum Beispiel von menschlichem Verhalten lernen – zum Beispiel, weil Personaler eher die männlichen Profile bevorzugen oder aber der Algorithmus gelernt hat Rückschlüsse auf Geschlecht oder Ethnie zu ziehen.“

Viele Start-ups, die sich auf den Bereich der Personalsuche konzentriert haben, nutzen aber die Macht der Algorithmen, gerade weil sie das menschliche Vorurteil umgehen wollen.

Darunter zum Beispiel das deutsch-amerikanische Unternehmen Smartrecruiters – das Start-up bietet Kunden automatisierte Hilfe beim Besetzen von leeren Stellen – zu den Kunden zählen Ikea, Bosch oder Visa. Smartrecruiters vermittelt nach eigenen Angaben derzeit knapp 1,2 Millionen Menschen pro Monat in einen Job.

Zuletzt launchte es den sogenannten „Smartrecruiting Assistent“, ein Werkzeug, das mittels Algorithmen geeignete Kandidaten findet, erklärt Geschäftsführer Robin Haak: „Unsere Technologie liest innerhalb von wenigen Minuten geeignete Lebensläufe durch und überprüft zum Beispiel erforderliche Uni-Abschlüssen oder Sprachkenntnisse und trifft so eine Vorauswahl.“

Das erspare den Personalern nicht nur wertvolle Zeit, sondern umgehe auch menschliche Vorurteile: Den Algorithmus interessiere schließlich nicht, welches Geschlecht oder Hautfarbe man habe, erklärt Haak: „Klar kann dann am Ende immer noch der Typ im Bewerbungsgespräch bevorzugt werden, mit dem man gut Golf spielen kann – aber das ist weitaus schwerer als schon im Vorfeld systematisch Kandidaten auszusieben.“

Auch Daniel Barke, Mitgründer von Mylittlejob, warnt beim Thema Algorithmen vor Einseitigkeit: „Sowohl Warner als auch Befürworter sollten die Vor- und Nachteile bedenken.“ Mylittlejob vermittelt akademischen Nachwuchs an Unternehmen, die Nebenjobs ausschreiben – in Deutschland und den USA.

Dabei setzt Barke auch auf Algorithmen – und glaubt, dass sie die Objektivität fördern: „Bei einem Algorithmus spielen Alter, Hautfarbe oder Religion keine Rolle – das ist im analogen Leben leider nicht immer so.“ Zudem seien die Momente, wenn Diskriminierung passiere, gar nicht immer gewollt, so Barke:

„Manchmal mag jemand auch einfach ein Gesicht nicht.“ Ein Algorithmus könne Subjektivität und Unterbewusstsein ausschalten und eine Entscheidung rein auf Grund von Leistungsaspekten treffen.

Barke beobachtet in den USA schon länger die Diskussion, ob ein exzellenter Student einer staatlichen Universität nicht besser geeignet sei für eine Stelle als ein mittelmäßiger von einer Elitehochschule: „Das Signal Harvard ist für viele Personaler immer noch ein entscheidendes Thema“, meint Barke. Ein Algorithmus kenne das nicht.

Doch bei allen Vorurteilen, auch Barke kennt die Schattenseiten: „Ein Algorithmus ist immer nur so gut, wie er programmiert ist.“ Gerade wenn das automatisierte Dazulernen hinzukomme, müsse das Fundament richtig gelegt sein: „Damit aus Daten nicht selbst Vorurteile ableitet werden.“

Auch Forscherin Hannak gibt zu bedenken: „Jeder der einen Algorithmus erschafft, muss sich extrem bewusst darüber sein, welche Entscheidung er treffen und was er lernen soll.“

Es müsse konstant Überprüfung stattfinden, meint die Expertin: „Es gibt keine Garantie dafür, dass sich der Algorithmus nicht doch das menschliche Vorurteil irgendwann zu eigen macht.“

Yahoo Kino

Yahoo Kino